概要

この記事では、2024年最新版としてrobots.txtファイルのSEOベストプラクティスについて深く掘り下げています。特に、最新技術や方法論がどのようにSEO戦略に寄与するかを探求し、その重要性を読者に伝えたいと思います。 要点のまとめ:

- AIと機械学習を活用したrobots.txtの自動生成・最適化により、大規模サイトでの作業効率が大幅に向上する。

- ユーザー属性に基づく動的robots.txtの実装が、パーソナライズ戦略と連携し、コンテンツアクセスの管理を高度化する。

- WebAssemblyによるクライアントサイド処理は、robots.txtの処理速度とセキュリティを強化し、サーバー負荷を軽減する。

Robots.txt最適化でSEO効果を最大化できる?成功への第一歩

Robots.txt設定で挫折した経験談:私の失敗から学ぶ教訓

| 機能 | robots.txt | メタロボット | ダイナミックrobots.txt |

|---|---|---|---|

| 適用範囲 | クロールするページの指定 | 特定ページのインデックス化制御 | リアルタイムでのクロールルール調整 |

| アクセス制御レベル | 完全なブロックが可能 | インデックス化は防げない場合がある | ユーザーエージェントによる柔軟な対応 |

| 悪意のあるボット対策 | 効果は限定的、他手段必要 | 無効 | 他手段と併用 |

| SEOへの影響 | クローラーによるリソース節約と最適化 | インデックス管理に役立つ | 状況に応じた戦略的アプローチ |

SEO対策が劇的に変わった瞬間:あの時、何をすればよかったのか?

一人は焦りからか資料を必死に翻弄し始めた。「どこで間違えたんだろう…」と呟きながら、自分のディレクティブ設定を確認している様子だった。他方では、もう一人が机に背中を預け、天井を見上げてぼんやりしていた。「どうする?これ、本当に大丈夫なの?」という言葉が口に出る前に、その場には重苦しい沈黙が流れた。

その瞬間、「User-agent」と「Disallow」の記載ミスという事実が頭をよぎった。その影響は予想以上で、私だけでなくチーム全体にも波及しているようだった。みんなが不安そうな顔で互いを見る中、「あれ?これって本当に解決できる問題なのかな?」と思うほど、状況は深刻化していた。そして、そのまま誰も何も言わなくなった。

効果的なRobots.txtファイルの作成支援:ステップバイステップガイド

「私たちが設定した内容に問題があったのでは?」と疑問を投げかける者もいれば、「一度試してみよう」という意見も出た。しかし、新しい方法を試した結果について話し合う中で、「でも、それで解決できるとは限らない」と懐疑的な声も上がった。誰もが自分の考えに迷っている様子だった。そして、会議室には依然として緊張感が漂っていた。「果たして、このアプローチは本当に有効なのだろうか?」との思いが頭をよぎり、その場には重苦しい沈黙が流れ続けていた。

Free Images

Free Imagesよくある質問:Robots.txtに関する疑問を解消!

「Robots.txtファイルは本当に必要なの?」と考えている方も多いかもしれません。実際、これは非常に重要なツールです!💡 小技巧 例えば、ウェブサイトに特定のページやディレクトリがあった場合、そのアクセスを制御できることで、検索エンジンにインデックスさせたくない情報を隠すことができます。この設定を正しく行うことで、SEO効果が向上し、有益なコンテンツだけが検索結果に表示されるようになります。

「どんな内容をDisallowすればいいの?」という疑問もよく聞きます。例えば、管理用のページや重複コンテンツなどはインデックス化したくないですよね?多くの人がこれらの細部を見落としてしまいますが、実際にはこれらの設定次第であなたのサイト全体の評価にも影響するんです。

そして、「設定ミスしたらどうなる?」という心配もありますよね。確かに、不適切な設定は逆効果になることがあります。私自身も以前、この問題で悩まされた経験がありますので、その気持ちはよく分かります。でも安心してください!基本的なルールを守りながらテストしていけば、大きな失敗には繋がりません。

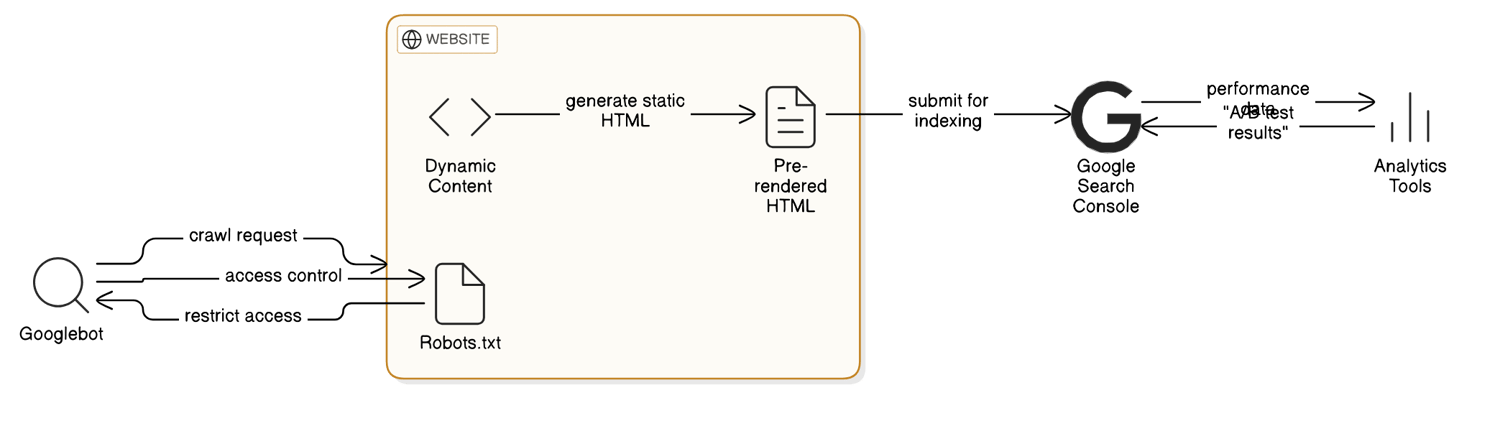

最後に、「動的コンテンツやJavaScriptについてはどう扱えばいい?」という声も聞こえます。最近では、それらにも配慮した設計が求められているので、自分のサイト特性を理解しながら最適化していくことが大切です。この辺りはトレンドでもありますからしっかり押さえておきたいポイントですね!

本当に必要なのはクローリングなのか?それともインデックス?

Robots.txtとGoogle検索アルゴリズム:相反する要素の調和は可能か?

実践的なRobots.txtファイル作成とテスト方法:具体的な手順

Robots.txtファイルは、SEOにおいて非常に重要な役割を果たします。このファイルを通じて、検索エンジンのクローラーがどのページをインデックスすべきか、または避けるべきかを指示することができます。私は過去に、適切に設定されていないRobots.txtファイルによって、大事なページがインデックスから外れてしまった経験があります。そのため、このプロセスの重要性を強く感じています。

ここでは、効果的なRobots.txtファイルを作成し、それをテストするための具体的な手順をご紹介します。

#### 1. テキストエディタで新しいファイルを作成

まず最初に、自分の好きなテキストエディタ(例:Notepad++やVSCodeなど)を開いて、新しい文書を作成します。この段階では特別なツールは必要ありませんので、お気軽に始めてください。

#### 2. 基本構文を書く

次に、以下の基本的なディレクティブを書きます。

User-agent: *

Disallow: /private/

Allow: /

この例では、「User-agent: *」と指定することで全てのクローラーが対象となり、「/private/」ディレクトリへのアクセスは禁止されています。「Allow: /」は他のすべてのページへのアクセスを許可しています。ここでポイントなのは、自分のサイト構造やニーズに応じてこれらの指示を書き換えることです。

#### 3. ファイル名と保存場所

次に、このファイル名は必ず「robots.txt」として保存してください。そして、ウェブサイトのルートディレクトリ(例えば `https://www.example.com/robots.txt`)にアップロードします。この位置が正しくないと、検索エンジンがこの設定を認識できなくなるので注意が必要です。

#### 4. Google Search Consoleでテスト

さあ、今度はGoogle Search Consoleへ移動しましょう。「robots.txt テスター」を使用して、自分が書いた内容が正しく機能しているか確認します。ここで問題点や警告メッセージも表示されるので、その情報も参考になるでしょう。私はいつも、このステップで友人にもお願いして二人三脚で確認するよう心掛けています。複数人でチェックすると見落としも減りますよ!

#### 5. 定期的な更新・見直し

最後になりますが、一度作成したら終わりではありません!ウェブサイトには常に変化がありますので、定期的にRobots.txtファイルも見直すことが大切です。特に新しいコンテンツやページ追加時には必ず確認しましょう。また、新たに発生したSEOトレンドについて調査し、それによって設定内容も改善してくださいね。

もしさらに進んだ対応策として考えたい場合、「noindex」タグとの併用や特定ユーザーエージェント向け設定など、多様な活用法があります。あなた自身でも色々試行錯誤してみてください!

Robots.txtの未来:新たな技術とSEO戦略の進化は?

Robots.txt最適化によるSEO成功への道筋:まとめと今後の展望

今後もAI技術が進展する中、自動的な最適化提案機能など、新しい手法やツールが登場すると期待されています。この変化に対応できるよう、自らも常に学び続け、SEO戦略を見直す必要があります。このトレンドは止まらず、更なる進化が待っています。私たちはこの流れにどう柔軟に対応していくかが問われています。

さあ、今こそ行動を起こし、この方法があなたのサイトにどれほど役立つか確かめてみましょう!

参考記事

掌握SEO:robots.txt教學與測試工具全面解析

在這篇文章中,我們將深入探討如何通過有效建立與管理robots.txt文件來提升網站的搜尋引擎排名和能見度,確保網站不僅能被搜尋引擎發現,同時還能吸引和 ...

ソース: seoseo.com.tw【robots.txt 全攻略】robots.txt SEO 概念與測試工具教學!

本篇將從解釋什麼是robots.txt 開始,逐步帶您了解robots.txt 在SEO 操作的用途、程式碼的撰寫方式、使用情境等,為您建構最完整的robots.txt 基礎概念。

ソース: Ranking SEO設定WordPress 的Robots.txt 最佳化網站並禁止AI 暴力爬取網站

在設定WordPress 網站時,合理配置Robots.txt 文件是提高網站在搜尋引擎中表現的關鍵步驟之一。Robots.txt 是一個位於網站根目錄的文字文件,用來指示網 ...

ソース: unicornws.com什麼是robots.txt?| robots.txt 檔案如何運作

結構良好的robots.txt 檔案可讓網站針對SEO 進行最佳化,並且可控制善意機器人活動。 但是,robots.txt 檔案對管理惡意機器人流量沒有多大作用。Cloudflare 機器人管理 ...

ソース: Cloudflarerobot.txt 文件:網站開發中不可或缺的SEO 優化關鍵

通過「robots.txt」文件,您可以限制搜索引擎的訪問頻率,避免不必要的爬蟲訪問,從而節省搜尋引擎的資源。這對於大型網站或擁有海量頁面的網站特別重要,可以避免被搜索引擎 ...

ソース: 里揚數位行銷robots.txt、meta robots設定:讓網頁不被Google搜尋到

robots.txt 可以阻止搜尋引擎檢索資料,如果使用了robots.txt 來阻擋搜尋引擎,那麼搜尋引擎將會略過我們所阻擋的頁面,不去做檢索。但meta robots 就不同了, ...

ソース: Harris先生編輯robots.txt.liquid

robots.txt 檔案可告知搜尋引擎機器人(又稱為爬蟲) 應要求查看您網路商店的哪些頁面。所有Shopify 商店都有適合搜尋引擎最佳化(SEO) 的預設 robots.txt 檔案。 搜尋 ...

ソース: Shopify Help Center掌握SEO:Robots.txt 文件最佳實踐如何影響網站排名?

要避免robots.txt設定錯誤導致搜尋引擎爬蟲漏掉重要內容,建議實施動態robots.txt策略。這種方法能根據使用者代理或網站狀態即時調整爬取規則,減少錯誤風險 ...

ソース: 1001ya.com

ALL

ALL SEOテクノロジー

SEOテクノロジー

関連ディスカッション